kubernetes(k8s):容器资源限制(内存限制、cpu限制、namespace限制) |

您所在的位置:网站首页 › docker cpu要求 › kubernetes(k8s):容器资源限制(内存限制、cpu限制、namespace限制) |

kubernetes(k8s):容器资源限制(内存限制、cpu限制、namespace限制)

|

文章目录

1. k8s容器资源限制2. 内存资源限制实例3. cpu资源限制4. namespace设置资源限制5. namespace中pod的配额6. namespace的创建、使用和删除7. 清除资源限制和配额

1. k8s容器资源限制

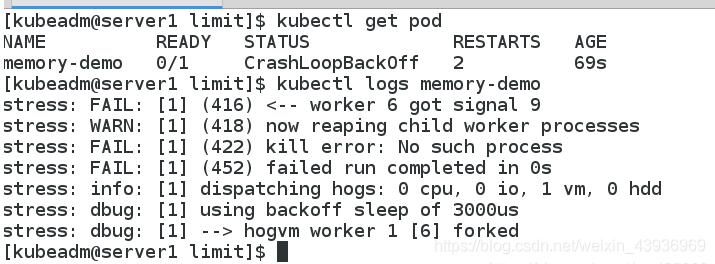

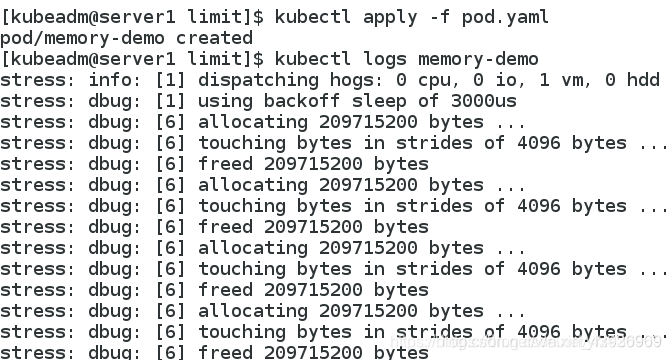

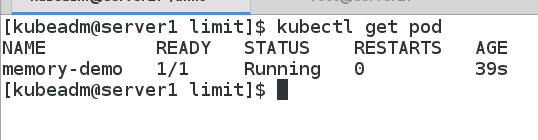

k8s采用request和limit两种限制类型来对资源进行分配 request(资源需求):即运行pod的节点必须满足运行pod的最基本需求才能运行pod。limit(资源限制):即运行pod期间,可能内存使用量会增加,那最多能使用多少内存,这就是资源限额。资源类型: CPU的单位是核心数,内存的单位是字节。一个容器申请0.5各CPU,就相当于申请1个CPU的一半,可以加个后缀m表示千分之一的概念。比如说100m的CPU,100豪的CPU和0.1个CPU都是一样的。内存单位: K,M,G,T,P,E #通常是以1000为换算标准的。Ki,Mi,Gi,Ti,Pi,Ei #通常是以1024为换算标准的。 2. 内存资源限制实例 [kubeadm@server2 limit]$ cat pod.yaml apiVersion: v1 kind: Pod metadata: name: memory-demo spec: containers: - name: memory-demo image: stress args: - --vm - "1" - --vm-bytes - 200M // 容器使用200M resources: requests: //资源需求,下限 memory: 50Mi limits: //资源限制,上限 memory: 100Mi [kubeadm@server1 limit]$ kubectl get pod NAME READY STATUS RESTARTS AGE memory-demo 0/1 CrashLoopBackOff 3 106s因为容器需要200M,超出了最大限制100Mi,所以容器无法运行。 如果容器超过其内存限制,则会被终止。如果可重新启动,则与其他所有类型的运行故障一样,kubelet将重新启动它。如果一个容器超过其内存要求,那么当节点内存不足时,它的pod可能被逐出。

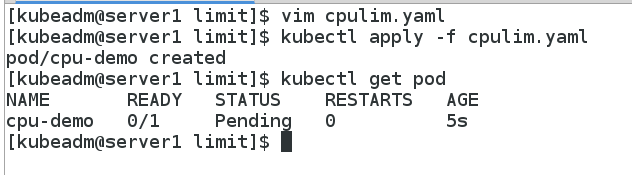

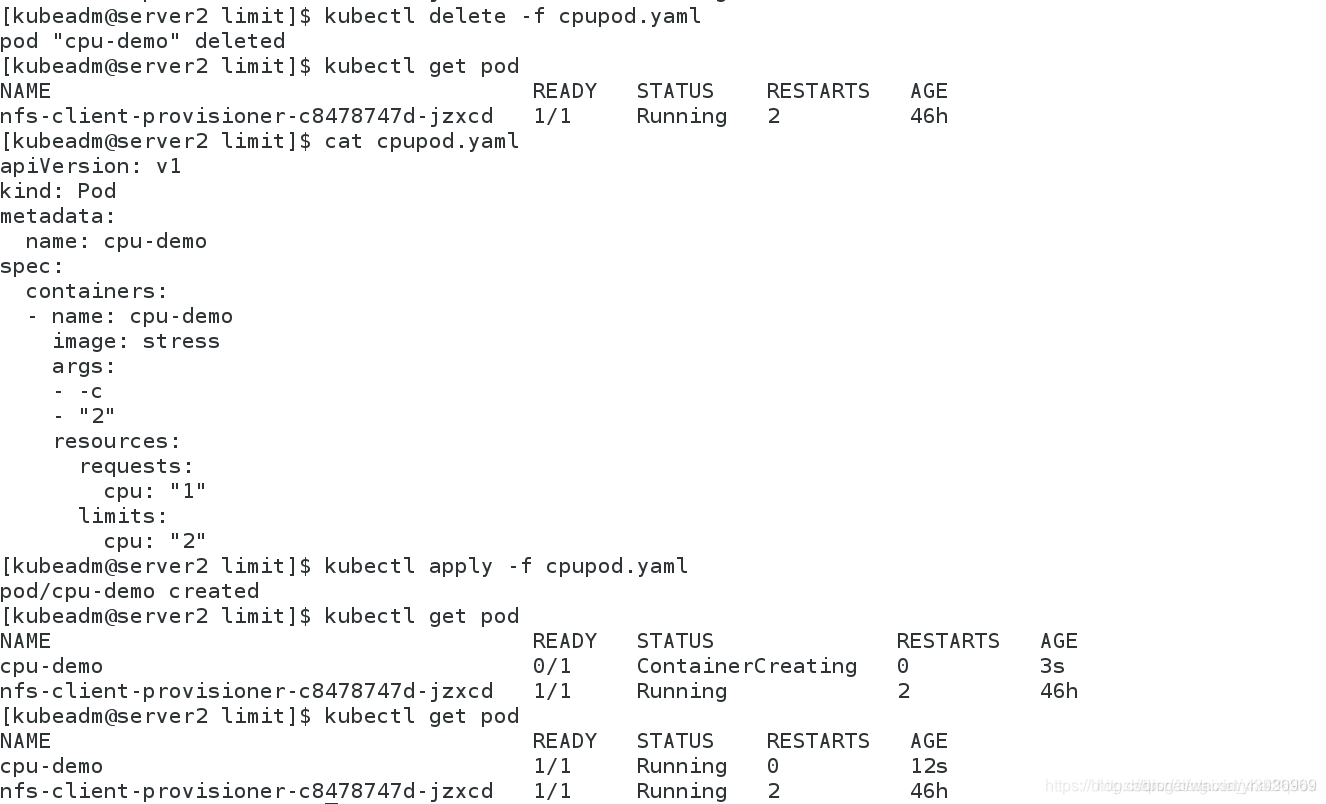

调度失败是因为申请的CPU资源超出集群节点所能提供的资源 但CPU 使用率过高,不会被杀死

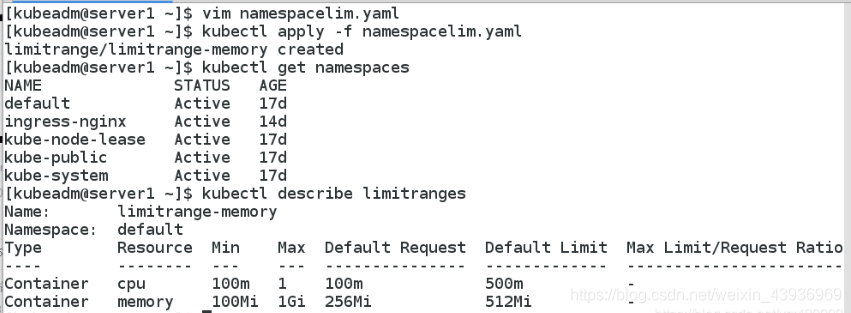

LimitRange资源限制: apiVersion: v1 kind: LimitRange metadata: name: limitrange-memory spec: limits: - default: //默认使用0.5个cpu,512mi内存 cpu: 0.5 memory: 512Mi defaultRequest: //默认要求0.1个cpu和256mi内存 cpu: 0.1 memory: 256Mi max: //最大2个cpu和1gi内存 cpu: 1 memory: 1Gi min: //最小0.1个cpu和100mi内存 cpu: 0.1 memory: 100Mi type: Container [kubeadm@server1 limit]$ kubectl apply -f limitrange.yaml limitrange/limitrange-memory created [kubeadm@server1 limit]$ kubectl get limitranges NAME CREATED AT limitrange-memory 2020-05-08T08:52:10Z [kubeadm@server1 limit]$ kubectl describe limitranges Name: limitrange-memory Namespace: default Type Resource Min Max Default Request Default Limit Max Limit/Request Ratio ---- -------- --- --- --------------- ------------- ----------------------- Container cpu 100m 2 100m 500m - Container memory 100Mi 1Gi 256Mi 512Mi -注意:LimitRange 在 namespace 中施加的最小和最大内存限制只有在创建和更新 Pod 时才会被应用。改变 LimitRange 不会对之前创建的 Pod 造成影响。 LimitRange - default xx会自动对没有设置资源限制的pod自动添加限制

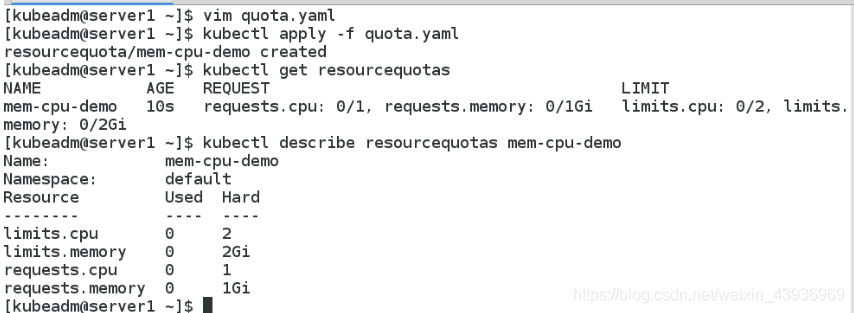

4种请求:每个容器必须设置内存请求(memory request),内存限额(memory limit),cpu请求(cpu request)和cpu限额(cpu limit) 资源会统计总的namespace中的资源加以限定,不管是之前创建还是准备创建 创建的ResourceQuota对象将在default名字空间中添加以下限制: 每个容器必须设置内存请求(memory request),内存限额(memory limit),cpu请求(cpu request)和cpu限额(cpu limit)。所有容器的内存请求总额不得超过1 GiB。所有容器的内存限额总额不得超过2 GiB。所有容器的CPU请求总额不得超过1 CPU。所有容器的CPU限额总额不得超过2 CPU。 5. namespace中pod的配额 [kubeadm@server1 limit]$ cat podquata.yaml apiVersion: v1 kind: ResourceQuota metadata: name: pod-demo spec: hard: pods: "2" //2个pod设置Pod配额以限制可以在namespace中运行的Pod数量。 [kubeadm@server1 limit]$ kubectl apply -f podquata.yaml resourcequota/pod-demo created [kubeadm@server1 limit]$ kubectl describe resourcequotas pod-demo // 当前只有一个pod Name: pod-demo Namespace: default Resource Used Hard -------- ---- ---- pods 1 2 [kubeadm@server1 limit]$ cat pod.yaml apiVersion: v1 kind: Pod metadata: name: test spec: containers: - name: test image: nginx //创建一个pod [kubeadm@server1 limit]$ kubectl apply -f pod.yaml pod/test created [kubeadm@server1 limit]$ cat pod.yaml apiVersion: v1 kind: Pod metadata: name: test1 spec: containers: - name: test1 image: nginx //再创建一个pod时,会发生错误,因为在当前的namespace中限制两个pod [kubeadm@server1 limit]$ kubectl apply -f pod.yaml Error from server (Forbidden): error when creating "pod.yaml": pods "test1" is forbidden: exceeded quota: pod-demo, requested: pods=1, used: pods=2, limited: pods=2当然,以上设定对应相对的namespace,其它的namespace没有影响 为了后续不受影响,删除相应的设定

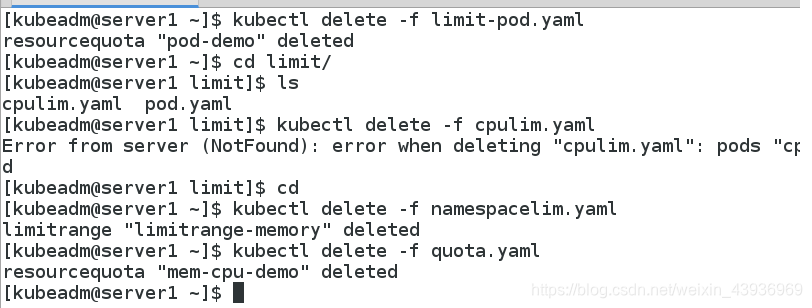

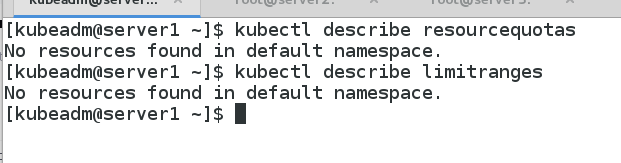

创建namespace kubectl create namespace test // 创建test的namespace运行yaml文件时指定namespace kubectl apply -f pod.yaml -n test // 在test的namespace中运行pod.yaml为文件删除namespace kubectl delete namespaces test // 删除名为test的namespace 7. 清除资源限制和配额 [kubeadm@server1 limit]$ kubectl delete -f limitrange.yaml limitrange "limitrange-memory" deleted [kubeadm@server1 limit]$ kubectl delete -f podquata.yaml resourcequota "pod-demo" deleted [kubeadm@server1 limit]$ kubectl delete -f quota.yaml resourcequota "mem-cpu-demo" deleted |

【本文地址】

今日新闻 |

推荐新闻 |

资源限制内部机制使用的是cgroup类型 目录: /sys/fs/cgroup/systemd

资源限制内部机制使用的是cgroup类型 目录: /sys/fs/cgroup/systemd 满足要求

满足要求

ResourceQuota设置配额限制

ResourceQuota设置配额限制 一旦设置配额后,后续的容器必须设置请求(4种请求都设置),当然,这只是在rq设置的defult的namespace中

一旦设置配额后,后续的容器必须设置请求(4种请求都设置),当然,这只是在rq设置的defult的namespace中